編輯:編輯部

【新智元導讀】人大系初創公司智子引擎發布的全新多模態大模型Awaker 1.0,直接邁向了AGI!它是業界首個真正實現自主更新的大模型,在寫真視頻效果上,居然擊敗了Sora。在4月27日召開的中關村論壇通用人工智能平行論壇上,人大系初創公司智子引擎隆重發布全新的多模態大模型Awaker 1.0,向AGI邁出至關重要的一步。

相對于智子引擎前代的ChatImg序列模型,Awaker 1.0采用全新的MOE架構並具備自主更新能力,是業界首個實現「真正」自主更新的多模態大模型。

在視覺生成方面,Awaker 1.0采用完全自研的視頻生成底座VDT,在寫真視頻生成上取得好于Sora的效果,打破大模型 「最後一公裏」落地難的困境。

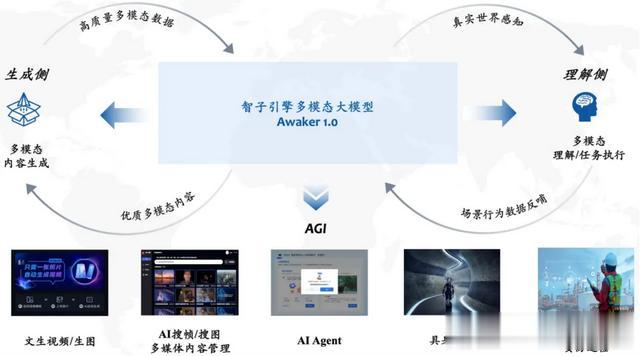

Awaker 1.0是一個將視覺理解與視覺生成進行超級融合的多模態大模型。

在理解側,Awaker 1.0與數字世界和現實世界進行交互,在執行任務的過程中將場景行爲數據反哺給模型,以實現持續更新與訓練;在生成側,Awaker 1.0可以生成高質量的多模態內容,對現實世界進行模擬,爲理解側模型提供更多的訓練數據。

尤其重要的是,因爲具備「真正」的自主更新能力,Awaker 1.0適用于更廣泛的行業場景,能夠解決更複雜的實際任務,比如AI Agent、具身智能、綜合治理、安防巡檢等。

Awaker的MOE基座模型

在理解側,Awaker 1.0的基座模型主要解決了多模態多任務預訓練存在嚴重沖突的問題。

受益于精心設計的多任務MOE架構,Awaker 1.0的基座模型既能繼承智子引擎前代多模態大模型ChatImg的基礎能力,還能學習各個多模態任務所需的獨特能力。

相對于前代多模態大模型ChatImg,Awaker 1.0的基座模型能力在多個任務上都有了大幅提升。

鑒于主流的多模態評測榜單存在評測數據泄露的問題,我們采取嚴格的標准構建自有的評測集,其中大部分的測試圖片來自個人的手機相冊。

在該多模態評測集上,我們對Awaker 1.0和國內外最先進的三個多模態大模型進行公平的人工評測,詳細的評測結果如下表所示。

注意到GPT-4V和Intern-VL並不直接支持檢測任務,它們的檢測結果是通過要求模型使用語言描述物體方位得到的。

可以看到,Awaker 1.0的基座模型在視覺問答和業務應用任務上超過了GPT-4V、Qwen-VL-Max和Intern-VL,同時它在描述、推理和檢測任務上也達到了次好的效果。

總體而言,Awaker 1.0的平均得分超過國內外最先進的三個模型,驗證了多任務MOE架構的有效性。下面是幾個具體的對比分析例子。

從這些對比例子可以看到,在計數和OCR問題上,Awaker 1.0能正確地給出答案,而其它三個模型均回答錯誤(或部分錯誤)。

在詳細描述任務上,Qwen-VL-Max比較容易出現幻覺,Intern-VL能夠准確地描述圖片的內容但在某些細節上不夠准確和具體。

GPT-4V和Awaker 1.0不但能夠詳細地描述圖片的內容,而且能夠准確地識別出圖片中的細節,如圖中展示的可口可樂。

Awaker+具身智能:邁向AGI

多模態大模型與具身智能的結合是非常自然的,因爲多模態大模型所具有的視覺理解能力可以天然與具身智能的攝像頭進行結合。

在人工智能領域,「多模態大模型+具身智能」甚至被認爲是實現通用人工智能(AGI)的可行路徑。

一方面,人們期望具身智能擁有適應性,即智能體能夠通過持續學習來適應不斷變化的應用環境,既能在已知多模態任務上越做越好,也能快速適應未知的多模態任務。

另一方面,人們還期望具身智能具有真正的創造性,希望它通過對環境的自主探索,能夠發現新的策略和解決方案,並探索人工智能的能力邊界。通過將多模態大模型用作具身智能的「大腦」,我們有可能大幅地提升具身智能的適應性和創造性,從而最終接近AGI的門檻(甚至實現AGI)。

但是,現有的多模態大模型都存在兩個明顯的問題:一是模型的叠代更新周期長,需要大量的人力和財力投入;二是模型的訓練數據都源自現有的數據,模型不能持續獲得大量的新知識。

雖然通過RAG和長上下文的方式也可以注入持續出現的新知識,但是多模態大模型本身並沒有學習到這些新知識,同時這兩種補救方式還會帶來額外的問題。

總之,目前的多模態大模型在實際應用場景中均不具備很強的適應性,更不具備創造性,導致在行業落地時總是出現各種各樣的困難。

智子引擎此次發布的Awaker 1.0,是世界上首個具有自主更新機制的多模態大模型,可以用作具身智能的「大腦」。

Awaker 1.0的自主更新機制,包含三大關鍵技術:數據主動生成、模型反思評估、模型連續更新。

區別于所有其它多模態大模型,Awaker 1.0是「活」的,它的參數可以實時持續地更新。

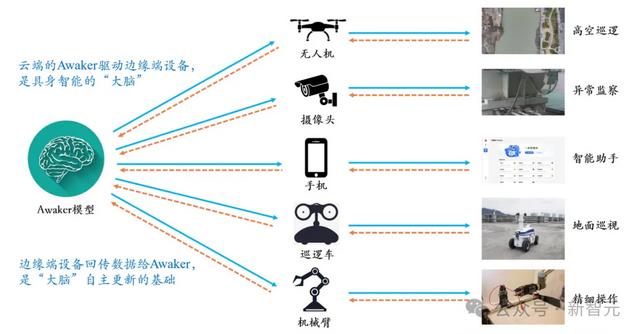

從上方的框架圖中可以看出,Awaker 1.0能夠與各種智能設備結合,通過智能設備觀察世界,産生動作意圖,並自動構建指令控制智能設備完成各種動作。

智能設備在完成各種動作後會自動産生各種反饋,Awaker 1.0能夠從這些動作和反饋中獲取有效的訓練數據進行持續的自我更新,不斷強化模型的各種能力。

以新知識注入爲例,Awaker 1.0能夠不斷地在互聯網上學習最新的新聞信息,並結合新學習到的新聞信息回答各種複雜問題。

不同于RAG和長上下文的傳統方式,Awaker 1.0能真正學到新知識並「記憶」在模型的參數上。

從上述例子可以看到,在連續三天的自我更新中,Awaker 1.0每天都能學習當天的新聞信息,並在回答問題時准確地說出對應信息。

同時,Awaker 1.0在連續學習的過程中並不會遺忘學過的知識,例如智界S7的知識在2天後仍然被Awaker 1.0記住或理解。

Awaker 1.0還能夠與各種智能設備結合,實現雲邊協同。

Awaker 1.0作爲「大腦」部署在雲端,控制各種邊端智能設備執行各項任務。邊端智能設備執行各項任務時獲得的反饋又會源源不斷地傳回給Awaker 1.0,讓它持續地獲得訓練數據,不斷進行自我更新。

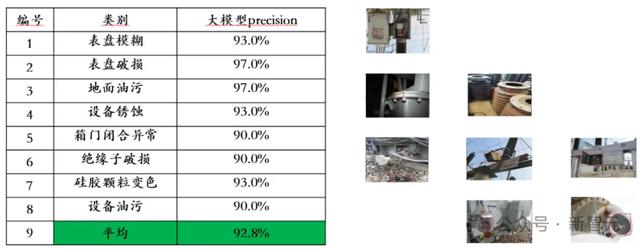

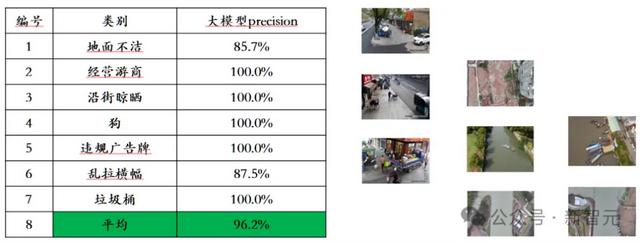

上述雲邊協同的技術路線已經應用在電網智能巡檢、智慧城市等應用場景中,取得了遠遠好于傳統小模型的識別效果,並獲得了行業客戶的高度認可。

現實世界的模擬器:VDT

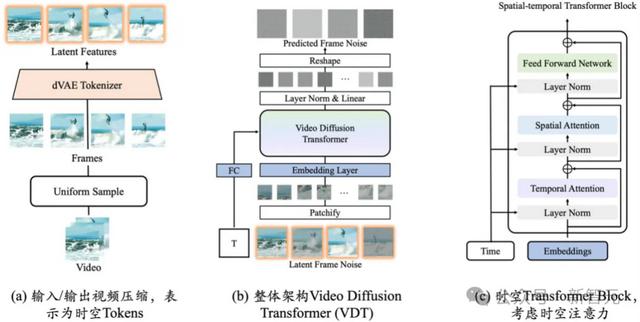

Awaker 1.0的生成側,是智子引擎自主研發的類Sora視頻生成底座VDT,可以用作現實世界的模擬器。

VDT的研究成果于2023年5月發布在arXiv網站,比OpenAI發布Sora提前10個月。VDT的學術論文已經被國際頂級人工智能會議ICLR 2024接收。

視頻生成底座VDT的創新之處,主要包括以下幾個方面:

將Transformer技術應用于基于擴散的視頻生成,展現了Transformer在視頻生成領域的巨大潛力。VDT的優勢在于其出色的時間依賴性捕獲能力,能夠生成時間上連貫的視頻幀,包括模擬三維對象隨時間的物理動態。提出統一的時空掩碼建模機制,使VDT能夠處理多種視頻生成任務,實現了該技術的廣泛應用。VDT靈活的條件信息處理方式,如簡單的token空間拼接,有效地統一了不同長度和模態的信息。同時,通過與時空掩碼建模機制結合,VDT成爲了一個通用的視頻擴散工具,在不修改模型結構的情況下可以應用于無條件生成、視頻後續幀預測、插幀、圖生視頻、視頻畫面補全等多種視頻生成任務。團隊重點探索了VDT對簡單物理規律的模擬,在Physion數據集上對VDT進行訓練。

在下面的示例中,團隊發現VDT成功模擬了物理過程,如小球沿抛物線軌迹運動和小球在平面上滾動並與其他物體碰撞等。同時也能從第2行第2個例子中看出VDT捕捉到了球的速度和動量規律,因爲小球最終由于沖擊力不夠而沒有撞倒柱子。

這證明了Transformer架構可以學習到一定的物理規律。

團隊還在寫真視頻生成任務上進行了深度探索。該任務對視頻生成質量的要求非常高,因爲我們天然對人臉以及人物的動態變化更加敏感。鑒于該任務的特殊性,我們需要結合VDT(或Sora)和可控生成來應對寫真視頻生成面臨的挑戰。

目前智子引擎已經突破寫真視頻生成的大部分關鍵技術,取得比Sora更好的寫真視頻生成質量。

智子引擎還將繼續優化人像可控生成算法,同時也在積極進行商業化探索。目前已經找到確定的商業落地場景,有望近期就打破大模型 「最後一公裏」落地難的困境。

未來更加通用的VDT將成爲解決多模態大模型數據來源問題的得力工具。

使用視頻生成的方式,VDT將能夠對現實世界進行模擬,進一步提高視覺數據生産的效率,爲多模態大模型Awaker的自主更新提供助力。

結語

Awaker 1.0是智子引擎團隊向著「實現AGI」的終極目標邁進的關鍵一步。

團隊認爲AI的自我探索、自我反思等自主學習能力是智能水平的重要評估標准,與持續加大參數規模(Scaling Law)相比是同等重要的。

Awaker 1.0已實現「數據主動生成、模型反思評估、模型連續更新」等關鍵技術框架,在理解側和生成側都實現了效果突破,有望加速多模態大模型行業的發展,最終讓人類實現AGI。