利用 Ollama 開源模型倉庫和 Obsidian 筆記軟件搭建本地的大型語言模型,即大預言模型。這種方法的優勢在于保護個人隱私,並能夠結合個人知識庫來創建個性化的模型。

Ollama 模型倉庫Ollama 是一個提供多種大型語言模型的開源倉庫,用戶可以通過簡單的命令行操作來下載和運行這些模型。文章列出了 Ollama 支持的模型及其參數、大小和下載命令,包括但不限于 Llama 3、Mistral、Dolphin Phi 等。

安裝與配置 Ollama安裝:到官網下載Ollama 的 Windows 版,然後一鍵的傻瓜式安裝。

查詢模型:通過 ollama list 命令可以查詢已安裝的模型。

運行模型:使用 ollama serve 命令在 Windows 上運行模型,支持默認開機啓動。

模型安裝:比如安裝 llama3,只需在 cmd 中運行 ollama run llama3,便可安裝並運行該模型(其他模型安裝參考其他官網)。

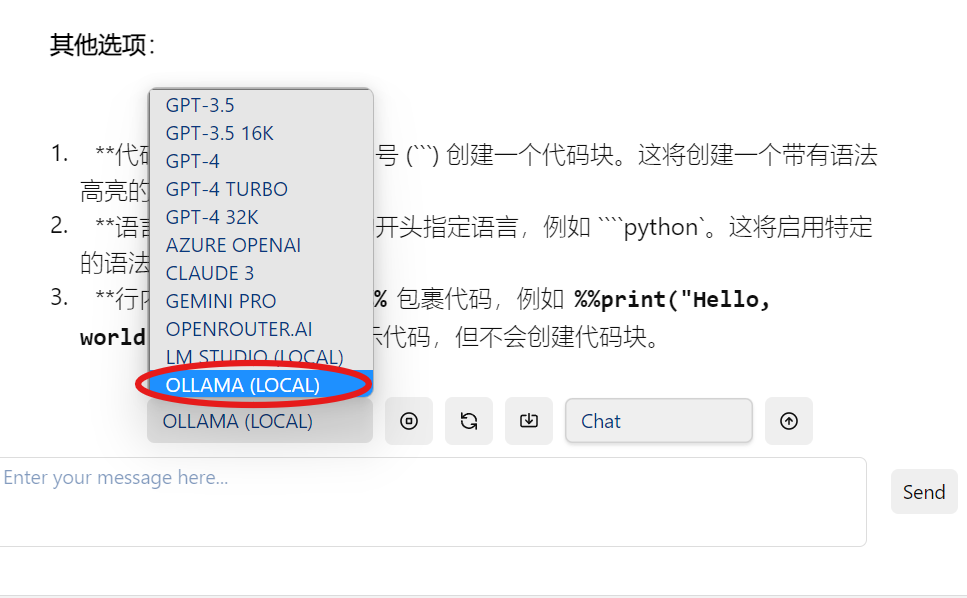

插件安裝:在 Obsidian 中安裝名爲 copilot 的插件,該插件允許用戶直接在 Obsidian 中利用 Ollama 模型。

文章指導用戶如何在Obsidian插件中添加環境變量 OLLAMA_ORIGINS=app://obsidian.md*,以確保 Ollama 模型能夠正確地與 Obsidian 集成。

完成上述設置後,用戶可以直接在 Obsidian 中使用 Ollama 模型。文章提到了兩種對話方式:

直接對話:用戶可以直接與模型進行交互。