Key Points

Gemini系列模型增加新成員Flash,但整體付費狀況堪憂;

最大亮點是Astra,與GPT-4o相似,以及Google Glass可能回歸;

類Sora模型Veo推出,長度夠了,清晰度還沒有;

AI搜索正式現身,但改名叫「AI Overview」了;

發布讓用戶自定義模型的Gems,對標OpenAI的GPTs;

Android有了更多系統級AI功能,第六代TPU新品也發布了。

今天淩晨1:00(當地時間5月14日10:00),2024年Google I/O全球開發者大會如期召開。就在24小時前,OpenAI用新模型GPT-4o再次震撼業界後,人們期待這家推出過AlphaGo、Transformer的科技巨頭能夠給予旗鼓相當的回應。

然而結果令人失望,在長達兩個小時的開幕主題演講上,這家公司既沒有推出能力更強的新模型,也沒有拿出充滿創意的新應用,有的只是乏善可陳的模型更新、老掉牙的産品用例,以及對競品的拙劣模仿——當Gemini産品總經理Sissie Hsiao自豪地宣布推出了一個名爲「Gems」的自定義模型新功能時,觀衆席一時間沉默得令人尴尬,該功能就連名字都是在抄作業(指OpenAI的GPT自定義服務GPTs),更別提後者發布已過去半年之久,模仿它的産品也早就出過一撥又一撥。

類似的冷場在演講中出現過不止一次。由于缺乏新鮮AI用例,而Google的每條産品線又不得不展示其與AI的聯系,最終呈現結果就是相似的用例反複在不同産品條線上出現。就比如讓AI做日程規劃這個功能,搜索産品提過,Gemini提過,到了Workspace又提了一遍。

對于這種狀況的樂觀理解是,Google已經像微軟那樣快速將GPT-4級的AI能力植入所有既有産品線,從搜索引擎到辦公套件;保守理解則是,生成式AI的模型能力目前還不足以令開發者構建更加原生和強大的殺手級應用——從推理能力到多模態能力都是如此。

Google DeepMind CEO Hassabis說公司目標仍然是AGI。

多模態能力看起來比推理能力更容易解決一點。在OpenAI昨天發布能看、能聽、能說的GPT-4o之後,Google也在今天發布了同類産品「Astra」,它能夠幾乎沒有延遲地就看到的事物與人互動,還和GPT-4o一樣能通過攝像頭解讀代碼和做數學題。不過,不幸的是,作爲整場發布會中唯一的亮點,Astra也沒有引起觀衆多少興奮,因爲他們昨天已經爲GPT-4o興奮過了。

整個發布會中,AI這個詞一共出現了121次,以下是值得關注的6大更新:

最大亮點是Astra,與GPT-4o相似;Google Glass可能回歸

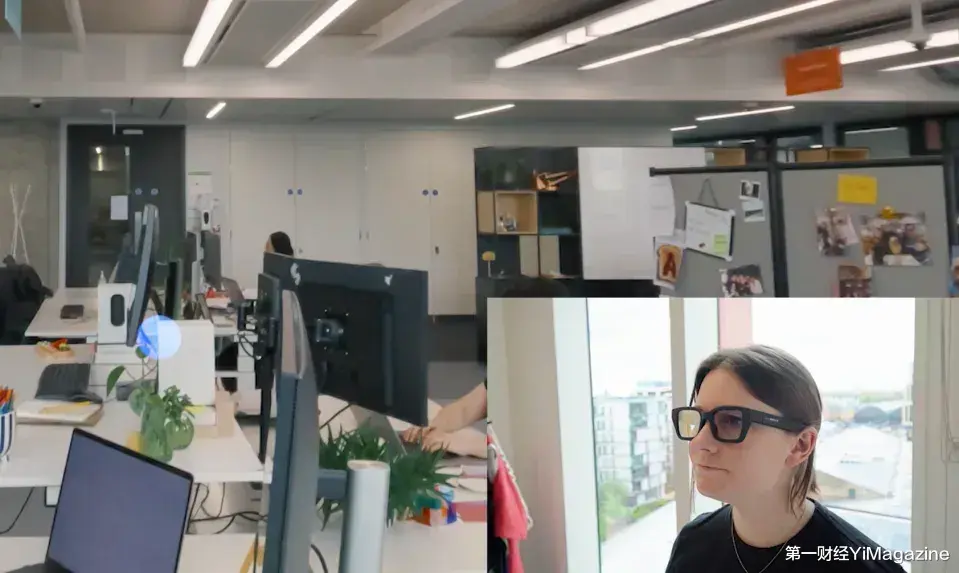

Google還展示了一個看起來與GPT-4o能力很相似的智能助手Astra,基于Gemini模型開發,它可以通過攝像頭「看到」周圍環境並做出解說。

演示中,Google DeepMind的一位産品經理拿著手機、開啓攝像頭帶著Astra在DeepMind位于倫敦的辦公室裏走了一圈,演示者讓它在「看到」會發出聲音的東西時告訴她,于是鏡頭中出現一個揚聲器時,Astra開口說話了「我看到一個揚聲器可以發出聲音」;「看到」辦公室電腦屏幕上的代碼,它能口頭講解這些代碼的意思;鏡頭轉向DeepMind辦公室窗外,它也能根據看到的景色猜測出自己所處的地理區域;而且,和24小時前OpenAI向外界展示的GPT-4o那樣,Astra也能對著鏡頭做數學題。

演示Astra的能力時,Google埋下了一個彩蛋:當演示者詢問「你是否看到過我的眼鏡在哪兒」時,即便當下視野中沒有眼鏡存在,Astra也能「根據記憶」告訴演示者「眼鏡在一個蘋果旁邊」,因爲在它經過辦公桌時,眼鏡和蘋果就曾出現在辦公桌上的電腦旁邊。接著,這位演示者拿起了蘋果前的眼鏡戴上,這幅眼鏡看起來並不一般,它似乎裝有機載攝像頭,還有某種視覺界面。

演示者在Astra的「指點」下找到了眼鏡並戴上。

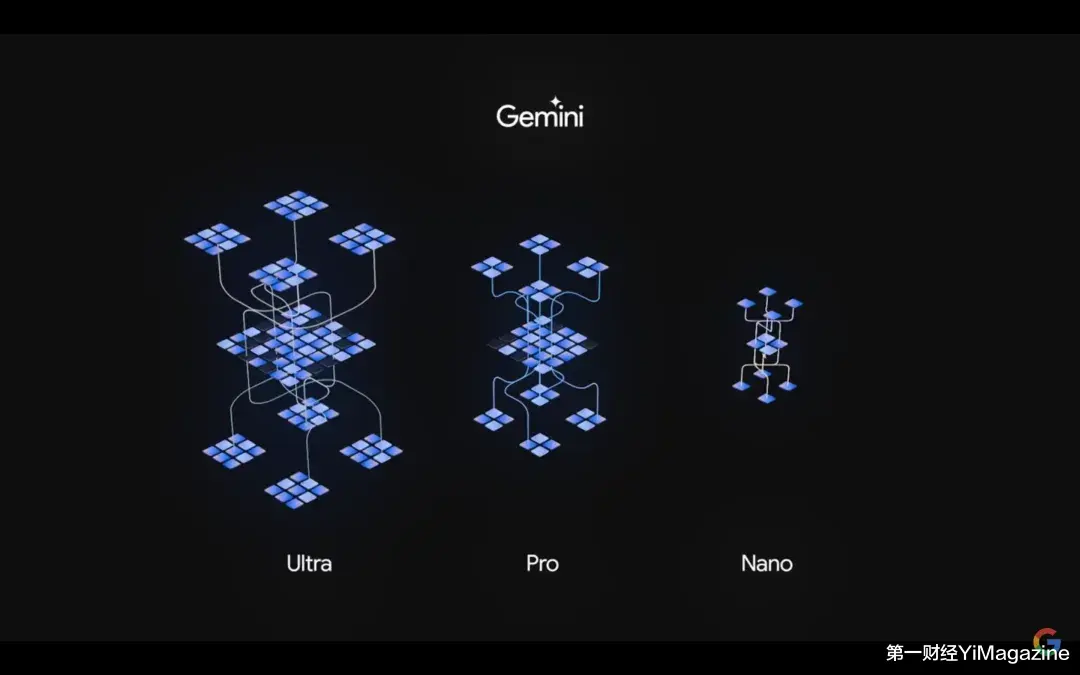

發布會結束後接受媒體采訪時,Google DeepMind CEO Demis Hassabis和Google聯合創始人Sergey Brin稱,Google正在探索爲Astra開發眼鏡的可行性。這令人猜測,已于去年3月15日暫停銷售的眼鏡産品Google Glass項目可能已經重啓。Gemini系列模型增加新成員Flash,但整體付費狀況堪憂去年12月6日,Google發布了對標GPT-4的多模態模型Gemini 1.0。該系列模型按照能力和size大小由弱到強分爲Nano、Pro、Ultra三個版本,分別適用于手機、廣泛設備和數據中心3種算力場景。其中,1.0 Pro和1.0 Ultra分別對標GPT-3.5和GPT-4。今年2月15日,這一系列模型升級爲Gemini 1.5。

今天的開發者大會上,Google爲該系列模型又增加了一個新模型Gemini 1.5 Flash,該模型在1.5 Pro版本上「蒸餾」得來,針對大批量、高頻次的任務做了優化,Google稱其比Pro版在反應速度和成本上都更有優勢。

其次,對于Gemini 1.5 Pro,團隊提升了其處理上下文的能力,上下文窗口從原來的100萬提升到200萬tokens,不過200萬上下文的模型還在內測中。

最後,對于專門針對移動設備研發的Gemini 1.0 Nano模型,團隊表示此前該模型只擁有文本推理能力,但未來將加入多模態能力,也就是說可以理解視頻、音頻和圖像能力要在未來版本的Nano模型中才推出。

1.0 Pro升級爲1.5 Pro後,Gemini目前共有4款閉源模型:Gemini 1.0 Ultra、Gemini 1.0 Nano,以及Gemini 1.5 Pro、Gemini 1.5 Flash。其中Gemini 1.5 Pro模型在能力上幾乎等同于Gemini 1.0 Ultra,Ultra版本前途未蔔。

今年2月8日,Google推出由Gemini 1.0 Ultra支持的高級服務Gemini Advanced,與ChatGPT Plus(20美元/月)幾乎相同,每月收費19.99美元。Google首席執行官Sundar Pichai提供的數據稱,已有超過100萬人注冊了Gemini Advanced服務,但沒有透露有多少人真正爲該産品付費。這一表現與OpenAI相距甚遠,後者的ChatGPT Plus據估計已有數百萬付費用戶,意味著OpenAI的付費用戶數量可能是Google的10到20倍,而其免費用戶數量已超過1億。

類Sora模型Veo推出,長度夠了,清晰度還沒有

在Gemini這一「原生」多模態模型之外,Google還更新或推出了新的圖像、音樂和視頻等單一生成模型。

其中圖像模型指的是最新的Imagen 3,團隊表示它生成的圖片細節更好,錯誤更少;對于音樂模型,Google並沒有透露模型名稱,只提到正在和一些音樂人合作試用。

其中,最重要的應該就是文生視頻模型Veo,這也是直接對標OpenAI Sora的模型。Google稱,Veo模型可以生成超過一分鍾的1080p分辨率視頻,並具有多種電影和視覺風格。不過,Google沒有透露技術細節。

Google展示的Veo生成視頻效果之一,視頻長達1分鍾,但清晰度堪憂。

Veo生成視頻效果之二。

AI搜索正式現身,但改名叫「AI Overview」了

據搜索團隊所說,這是首個從Google搜索實驗室畢業的AI功能,該功能將首先在美國推出,今年年底向所有用戶開放。

你可以將它看作是去年推出的實驗項目SGE(Search Generative Experience:生成式AI搜索)的階段性成果。當你搜索一些特定問題時(Google並沒有明確範圍),AI Overview功能會先搜索一系列相關網頁,對這些網頁內容做出總結後把答案直接呈現給用戶,而不是像先前那樣把一堆鏈接丟給用戶。開創這種模式的Perplexity AI創始人稱這種新模式爲「答案引擎」,對應傳統的「搜索引擎」。

Google並沒有表明「AI Overview」是否已取代SGE成爲Google AI搜索的專用名稱。在産品形態上,AI Overview與號稱是AI搜索引擎的Perplexity很相像,不過看起來Google並不准備將它作爲獨立應用推出。

除了AI Overview畢業外,還有以下4個新功能進入Google搜索實驗室深造。分別是Multistep reasoning(多步驟推理)、Planning(規劃功能)、AI organized search results(AI組織搜索結果)和Ask with Video(視頻提問)。

發布讓用戶自定義模型的Gems,對標OpenAI的GPTs

今年年初,Google將去年推出的聊天機器人Bard改名爲Gemini,與多模態模型Gemini同名。

在Gemini應用中,Google宣布推出模型自定義功能Gems,它就像OpenAI之前推出的GPTs一樣,可以讓用戶上傳獨有數據、定制屬于自己的Gemini聊天機器人。

此外,Gemini應用中最重要的新功能就是Gemini Live。借助這個功能,你可以通過語音的方式向Gemini提問,Gemini也同樣會用語音的方式回答,目前這個功能只向付費用戶開放。ChatGPT去年10月推出類似功能,並已于去年12月向免費用戶開放。

Google表示,今年晚些時候,Gemini Live將開放視頻能力,也就是你可以直接與它就攝像頭拍攝的事物做對話。不過暫不清楚該功能與DeepMind之前演示的Astra是否是同一個東西。

Android有了更多系統級AI功能,第六代TPU新品也發布了

今年年初就發布的Circle to Search(畫圈搜索)功能再次在此次開發者大會上被演示和強調。Google已將該功能加入三星等Android系手機。

此外,Android團隊還推出了TalkBack與詐騙電話實時監測兩個新功能。前者主要針對視力障礙人群,你可以讓AI助手讀取你手機屏幕的內容,並且用語音描述給你。後者用AI分析電話內容,當存在詐騙等風險時會彈窗提醒用戶。Android團隊難得提供了一些新鮮用例,可見更深入的AI應用還是需要與硬件底層結合。

蘋果和OpenAI也在開發能讀取和理解用戶屏幕的模型,比如OpenAI昨天展示的GPT-4o,就能讀取用戶屏幕中的數據圖,然後爲用戶講解。與GPT-4o對標的Astra並沒有展示這一點,演示中,它只能通過攝像頭看著電腦屏幕讀取,而沒有進入電腦操作系統內部。

最後,芯片團隊發布了最新一代AI芯片Trillium,該芯片與上一代TPU v5e相比,每個芯片的計算性能提高了4.7倍。該芯片將于2024年年末通過Google Cloud提供給客戶。